De nombreuses « lois » ont été proposées par les économistes depuis les travaux fondateurs des premiers économistes au 18e siècle. Ces « lois » ou « théorèmes » ont été imaginés à l’image des lois physiques et théorèmes mathématiques, alors que l’idée même de loi se discute dans le domaine économique.

À la différence de la physique1 ou de la biologie, l’économiste ne peut réaliser d’expérience contrôlée pour vérifier ses théories.2 Par exemple, il peut constater une corrélation entre l’augmentation du chômage et d’autres variables (l’inflation, l’évolution du commerce extérieur etc.), avancer des phénomènes explicatifs, mais il ne peut en déduire un lien de causalité précis et toujours vérifié -c’est-à-dire une loi- car il n’est pas possible de tester l’influence de telle ou telle cause « toutes choses égales par ailleurs ».3

Comme nous allons le voir dans cette fiche, la « loi de l’offre et de la demande », la « loi de Say », la « loi des rendements décroissants » ne sont pas des lois. Cette appellation est dangereuse car elle fait croire à un caractère universel et permanent, et donc intangible. De simples énoncés qui peuvent se révéler exacts dans des situations bien précises deviennent alors des dogmes. Dogmes qui sont encore renforcés par le fait que la majorité de ces « lois » s’appuient sur une démonstration mathématique plus ou moins sophistiquée qui leur donne une apparence de solidité qu’elles n’ont pas.

Dans cette fiche, nous allons lister les plus importantes, expliquer de manière simple comment elles ont été « démontrées » et résumer les principales critiques qui peuvent leur être faites.

L’absence de « lois économiques universelles » n’empêche pas de formuler des énoncés valides scientifiquement

Avant d’entrer dans l’analyse, rappelons un point important, l’absence de « lois économiques » ne signifie pas que tout serait nécessairement relatif en économie, que tout serait discutable et qu’on ne pourrait rien affirmer. Au contraire, la sphère économique est aujourd’hui bien trop structurante de la vie sociale et politique pour se contenter d’une approche « relativiste ».

Il est possible d’avancer des faits et des énoncés qui, sans être des lois physiques, sont solides scientifiquement, et qui, bien souvent, contredisent les analyses les plus répandues, en particulier parce que celles-ci ne tiennent aucun compte du socle physique et vivant sur lequel repose l’économie. Ne pas le faire, c’est laisser perdurer les dogmes actuels, faute d’alternative structurée.

On peut distinguer trois grandes catégories de ces faits et énoncés :

- ceux qui sont liés au fait que le système économique s’inscrit dans un monde physique et vivant, qui l’impacte et sur lequel il a un impact.

- ceux qui sont d’ordre comptable (ce sont souvent des vérités tautologiques ou purement descriptives). Par exemple : toute créance a une dette pour contrepartie ; le revenu de l’un est la dépense d’un autre ; réduire les dépenses publiques, c’est réduire les revenus de ceux (entreprises ou ménages) qui en bénéficiaient ; la monnaie est aujourd’hui créée par les banques par une simple écriture comptable.

- ceux qui sont issus de régularités empiriques sur de longues périodes. Il est par exemple avéré que la quantité d’heures travaillées n’a cessé de baisser en France depuis deux siècles et cette tendance est clairement corrélée à la mécanisation du travail. Ou encore : la part des salaires dans le PIB, en France, est à peu près constante de 1945 aux années 1980 et depuis, en diminution.

De ces régularités empiriques, l’économiste peut déceler des grandes « tendances » à différents moments de l’histoire ou dans différentes sociétés et en tirer des enseignements. Ce ne sont cependant pas des « lois », des règles intangibles et universelles. La vie économique s’inscrit dans un environnement naturel et social, produit de l’Histoire, des institutions, du cadre juridique. C’est pourquoi, il est toujours important de resituer les grandes idées économiques dans le contexte historique qui les a vu émerger.

La « loi » de l’offre et de la demande

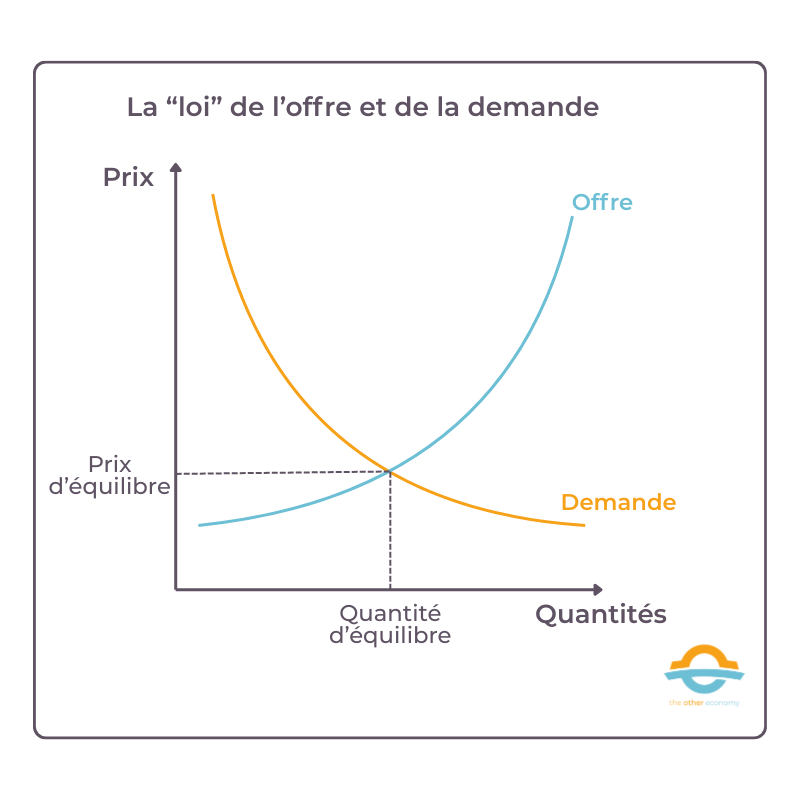

Cette loi énonce que lorsque l’offre d’un bien ou d’un service augmente tandis que la demande reste constante, le prix diminue, et inversement. Les prix seraient ainsi fixés par la confrontation entre l’offre et la demande du bien ou du service concerné4, le prix d’équilibre étant atteint quand la demande est égale à l’offre.

Elle est enseignée comme le B.A.-BA de l’économie. Elle est assez intuitive : nous avons tendance à acheter plus facilement ou en plus grande quantité un produit moins cher qu’un autre (à qualité égale). C’est le cas, par exemple, au moment des soldes. À l’inverse, plus un produit est cher, plus nous faisons attention à en limiter la consommation.

Mathématiquement, cette loi se démontre en utilisant un résultat très simple. On représente l’offre d’un bien par une fonction croissante du prix et la demande par une fonction décroissante. Ces deux courbes ont un point d’intersection qui définit le prix où l’offre est égale à la demande.

Schéma simplifié de la « loi » de l’offre et de la demande

Cette loi est fausse dans sa généralité

Les économistes à l’origine de cette théorie ont eux-mêmes identifié qu’il existe des biens de première nécessité (dits biens de Giffen) dont la demande augmente lorsque leur prix augmente dans un contexte de hausse générale des prix. En effet, dans ce cas, les populations pour lesquelles ce bien constitue une part importante du revenu seront obligées de renoncer à d’autres types de biens et augmenteront la consommation de ce bien pour compenser.

Il y a pourtant quelques exceptions. Par exemple, comme Sir R. Giffen l’a signalé, une élévation dans le prix du pain draine à tel point les ressources des familles ouvrières pauvres, et élève tellement l’utilité-limite de la monnaie pour elles, qu’elles sont obligées de réduire leur consommation en viande et en farineux les plus coûteux : et, le pain étant encore la nourriture la moins chère qu’elles puissent consommer, bien loin d’en consommer moins, elles en consomment davantage.

Alfred Marshall, Principe d’économie politique, 1890

Les biens de luxe constituent un autre exemple : ils peuvent voir leur demande augmenter avec leur prix, car ils servent de symbole de statut social.

Le prix repose avant tout sur les coûts de production : ceux-ci fixent un prix plancher, en dessous duquel, même avec une insuffisance de demande, une entreprise ne peut descendre durablement sans faire faillite. Pour les tenants de la loi de l’offre et de la demande, cette conséquence serait plutôt saine puisqu’elle permettrait d’éliminer les entreprises insuffisamment performantes.

La loi de l’offre et de la demande ne s’applique pas en cas de spéculation : pour un produit financier par exemple, plus le prix s’accroît, plus la demande peut être forte (logique de momentum). C’est également ce qui se passe sur les marchés des matières premières.

Enfin, il existe des produits à prix unique, comme le livre en France. Selon la théorie, le fait d’avoir un prix fixe devrait se traduire par une demande fixe (à laquelle l’offre devrait s’ajuster). Il est facile de constater que ce n’est clairement pas le cas.

La formulation mathématique de la loi est un exercice périlleux dès lors qu’on se confronte à la réalité

Plus fondamentalement, dès qu’on envisage de formuler cette « loi » de manière mathématiquement rigoureuse, les difficultés s’accumulent et il ne reste alors qu’un slogan flou, dont les conséquences en termes d’équilibre de marché n’ont aucun caractère d’évidence, comme nous le verrons en nous penchant sur la « loi » de l’équilibre général.

Voici quelques-unes des difficultés.

- Comment est défini précisément le marché des biens et services concernés ?

- Quels sont les produits concernés ? (par exemple tous les produits de boulangerie ? seulement les pains ? si oui quels pains ?…)

- De quelle qualité sont-ils ? (une pâtisserie vendue chez un artisan « Meilleur ouvrier de France » n’est pas concurrente d’une pâtisserie industrielle, qui peut être 10 fois moins chère… Un yaourt de vache au fruit concurrence-t-il un yaourt au soja ? etc.)

- Dans quelle zone géographique raisonne-t-on ? (dans une ville donnée ? une région ? un pays ?)

- Quels sont les « offreurs » à considérer (les producteurs, les intermédiaires, les vendeurs finaux ?)

- Quels sont les clients à considérer (les clients finaux ? les grossistes le cas échéant ? tous les types de surfaces de distribution ?)

- Sur quelle durée (certains produits, comme dans le secteur numérique, changent très vite… Du coup la forme de la loi et son paramétrage changent-ils tous les ans ?

- Comment formuler mathématiquement la loi de l’offre et de la demande pour le marché ainsi précisé ?

- Comment en vérifier la validité ?

- Peut-on déterminer des points de la courbe d’offre et de demande ? Il faut des quantités offertes, des demandes envisagées et des prix qui résulteraient de cette « confrontation » alors qu’en fait à chaque instant la seule information accessible c’est le prix d’un produit et les quantités vendues…

La “loi” de l’équilibre général

La loi de l’offre et de la demande est, comme on vient de le voir, une théorie assez floue. À la suite de Léon Walras5, les économistes ont tenté de représenter mathématiquement les marchés et de montrer qu’ils pouvaient conduire spontanément à un « équilibre général », situation où, sur tous les marchés, les offres et les demandes s’égaliseraient grâce à un prix d’équilibre.

On doit à Kenneth Arrow et Gérard Debreu d’avoir formalisé rigoureusement la théorie de l’équilibre général dans un article publié en 1959 au titre révélateur : The Existence of an Equilibrium for a Competitive Economy (Econometrica, 19546). Il est souvent enseigné que cet article démontre effectivement l’existence de cet équilibre.

Comme toujours en économie mathématique, la démonstration faite suppose de nombreuses simplifications et hypothèses. Voici certaines des plus saillantes et déterminantes dans la démonstration réalisée par Arrow et Debreu :

Les agents économiques sont supposés « rationnels »

Cette hypothèse n’est pas conforme à la réalité, comme l’ont montré de nombreuses études empiriques, et comme le sens commun nous l’enseigne directement sans besoin de démonstration. Pour en savoir plus sur le concept de rationalité en économie, consultez notre fiche La rationalité de l’homo economicus : une hypothèse infondée.

Leurs préférences sont représentées par une « fonction d’utilité » supposée convexe

La convexité des préférences signifie économiquement que le consommateur valorise la diversité et apprécie de consommer des quantités modérées de différents biens plutôt que de se concentrer sur un seul bien. Cette hypothèse est cohérente avec le principe de la décroissance de l’utilité marginale : plus on consomme d’un bien, moins l’utilité supplémentaire apportée par une unité additionnelle de ce bien est élevée. Donc diversifier sa consommation permet d’augmenter l’utilité totale.

Toute la question est de savoir si cette hypothèse est confirmée empiriquement…

Les préférences du consommateur sont supposées indépendantes de celles des autres

C’est évidemment contraire à tout ce qu’observent les psychologues, sociologues et anthropologues, pour lesquels le désir est mimétique. Une telle hypothèse est également contradictoire avec les méthodes du marketing et de la publicité, qui visent précisément à donner envie au consommateur à partir de la consommation supposée d’un modèle ou d’une référence sociale.

La concurrence est supposée parfaite

Une des conditions nécessaires pour que le marché soit parfaitement concurrentiel est l’atomicité du marché : il existe un grand nombre d’offreurs et de demandeurs, et tous ces agents économiques sont considérés comme des « preneurs de prix » ce que signifie que ce ne sont pas eux qui fixent les prix – ils les prennent, d’où qu’ils viennent. Cette dernière hypothèse est souvent présentée comme valable dans le cas de « petits » agents, dont les offres et les demandes individuelles se noient dans la masse. Dans la réalité, on constate de nombreuses situations de monopoles et d’oligopoles. Par ailleurs, la question centrale de savoir qui fixe les prix est laissée en suspens. Que les agents soient peu nombreux ou pas, il faut bien que quelqu’un le fasse. Ce mystère reste entier, la modélisation n’explique pas comment les prix se forment.

Les rendements sont supposés décroissants

Dans la réalité, les rendements sont croissants dans beaucoup de secteurs économiques, nous détaillons plus bas les limites de la loi des rendements décroissants.

Le système de marchés est supposé complet

Tous les biens présents et futurs7 sont supposés être échangés sur un marché et donc avoir un prix. Cette hypothèse est évidemment fausse.

Les décisions d’un agent n’affectent pas directement « l’utilité » ou la fonction de production des autres agents : il n’y a pas « d’externalités »

Le terme externalité désigne les répercussions positives ou négatives de l’activité d’un agent économique sur d’autres agents sans contrepartie monétaire marchande. Par exemple, les rejets d’une usine polluant une rivière ont des effets négatifs sur les usagers de l’eau, sans que l’entreprise n’ait rien à payer pour cela. Les activités économiques ont bien évidemment des effets variés et éventuellement considérables sur les humains et sur la Nature sans que cela donne lieu à un échange marchand. L’hypothèse d’absence d’externalité est évidemment fausse.

Les défaillances de marché : adapter la théorie à la réalité

Les économistes néoclassiques8 reconnaissent en règle générale le fait que ces hypothèses ne sont pas respectées dans le monde réel, et emploient alors l’expression «défaillance de marché ».

Par exemple, une externalité environnementale est une défaillance de marché. Dans ce cas, les mêmes économistes recommandent de « l’internaliser » (la réintroduire dans le marché) en lui donnant un prix (via une taxe environnementale telle la taxe carbone ou un mécanisme de marché de quotas comme le marché européen du carbone SEQE-EU).

Tous ces écarts entre la théorie et les faits montrent que les conclusions de la théorie ne sont pas fondées empiriquement.

Pour en savoir plus

- « L’Équilibre des marchés : un mythe à la vie dure malgré les faits » dans le module Marché, prix et concurrence de The Other Economy

- « La capacité d’autorégulation des marchés conduisant à une situation optimale aurait été démontrée scientifiquement » dans le module Marché, prix et concurrence de The Other Economy

- Fiche La rationalité de l’homo economicus : une hypothèse infondée, sur The Other Economy

- Fiche La fonction d’utilité en économie : définition et problèmes, sur The Other Economy

- Qu’est-ce que la concurrence parfaite ?, Bernard Guerrien, 2017

- L’équilibre néoclassique, sur le site Introduction à l’économie de Christophe Darmangeat

Les marchés financiers sont efficients

La « démonstration » de l’efficience des marchés financiers a valu à l’économiste américain Eugene Fama en 2013 le « prix Nobel d’économie »9 qu’il a partagé avec un autre économiste, Robert Shiller qui… conteste – à juste titre – cette idée, en affirmant au contraire que les marchés sont exubérants et irrationnels.10

Là aussi, cette idée a fait couler beaucoup d’encre.11 Le mathématicien Nicolas Bouleau en a fait une remarquable analyse critique, centrée sur la question sémantique et l’usage de la modélisation.

On voit qu’on tente ainsi de relier la notion économique d’efficience qui ne peut signifier autre chose que la « bonne » allocation des ressources (capitaux, investissement) de sorte qu’on évite les gaspillages, à des formalisations mathématiques concernant les processus aléatoires (martingales ou semi-martingales pour les prix actualisés, processus de Markov, filtrations).

Nicolas Bouleau, Critique de l’efficience des marchés financiers, 2013

La « loi » de Say

Selon cette loi, l’offre crée sa propre demande. En d’autres termes, la production totale d’une économie engendre un revenu suffisant pour acheter cette production. Il est bien exact que les entreprises productrices de biens ou de services dépensent l’argent qu’elles encaissent, qui est bien un revenu pour les salariés, les fournisseurs, les banquiers, les administrations et les actionnaires.

Mais l’apparente tautologie énoncée par cette loi est fausse car ce n’est pas la production qui engendre le revenu, mais la vente. Le pouvoir d’achat économique engendré par les entreprises est bien égal à leur vente, et non à leur production. Il peut y avoir des invendus (donc des constitutions de stocks) qui ne sont pas des revenus pour les entreprises et qu’elles ne peuvent donc pas dépenser de nouveau. C’est si vrai que le capitalisme a connu des crises dites de surproduction, dont la plus célèbre est celle de 1929 qui étaient en fait une crise de mévente. En 1929, les entreprises ne réussissant pas à vendre ce qu’elles ont produit ont fait faillite, ce qui a entraîné celle des banques.

Pour en savoir plus voir la Fiche Pour en finir avec la loi de Say, ou loi des débouchés sur The Other Economy.

Équivalence ricardienne et effet d’éviction

L’économiste anglais David Ricardo est le premier à avoir affirmé qu’il y aurait équivalence entre augmentation de la dette publique aujourd’hui et augmentation future des impôts levés par l’État pour rembourser cette dette et payer les intérêts. Par exemple, selon lui, il serait équivalent pour un État voulant financer une guerre de lever un nouvel impôt où d’émettre des titres de dette.

L’économiste Robert J.Barro a formulé mathématiquement cette idée dans un article de référence12 de 1974. Sa démonstration a été sophistiquée par James M. Buchanan en 1976.13

Pour ces auteurs (et tout le courant de pensée qui les suit, les « nouveaux économistes classiques »), les politiques budgétaires de relance sont inefficaces. En effet, selon eux, face à une relance budgétaire, les agents économiques prévoient une hausse future des impôts. Dès lors, ils ajustent leur niveau d’épargne (donc d’investissement) et de consommation de façon à neutraliser cette politique budgétaire. L’emprunt public exercerait donc, comme l’impôt, un effet d’éviction sur l’investissement privé.

La même conclusion est à tirer en cas de financement monétaire (du fait du « principe d’invariance » posé par Sargent et Wallace – voir point suivant). Les agents prévoient l’émission régulière de nouvelle monnaie et anticipent l’érosion de leur épargne par l’inflation. Dès lors, ils épargnent pour reconstituer la valeur réelle de leurs encaisses. Il n’y a donc aucun effet multiplicateur de la politique budgétaire14 sur la demande globale, contrairement à l’approche développée par l’économiste anglais John Maynard Keynes15 et ses successeurs.

Comme toujours, les modèles mathématiques utilisés reposent sur de nombreuses simplifications. Sans rentrer ici dans une analyse détaillée, citons les plus notables :

- L’économie est représentée par unmodèle d’équilibre général (qui repose donc sur une théorie très contestable comme vu plus haut) ultra simplifié, avec une fonction de production telle que les salaires sont égaux à la productivité marginale du travail16 et le capital est rémunéré à un taux d’intérêt unique.

- Les agents économiques sont supposés être capables « d’anticipations rationnelles » . Ils maximisent une fonction d’utilité intertemporelle à l’infini (ce qui signifie qu’ils sont altruistes par rapport à leurs descendants qu’ils considèrent avec le même intérêt qu’eux-mêmes).

- Les marchés financiers sont supposés parfaits (d’accès libre, transparents, sans coûts de transaction, avec des agents très nombreux, supposés rationnels, sans contrainte réglementaire).

- Les impôts sont supposés ne pas affecter les choix de consommation ou d’épargne.

- Les dépenses publiques sont supposées neutres, c’est-à-dire incapables de modifier les données économiques « réelles », et donc d’avoir un impact sur l’emploi ou la croissance.

La théorie des anticipations rationnelles

Introduite par l’économiste américain John Muth en 196117, cette théorie postule que les agents économiques sont capables d’analyser et d’anticiper le mieux possible la situation et les événements du monde qui les entoure, afin de prendre les meilleures décisions en vue de maximiser leur intérêt personnel (leur « utilité »). C’est, pour reprendre l’expression de Gaël Giraud18, « l’aptitude à prédire l’avenir ! Pour être plus précis : toutes les variables de l’avenir sont supposées suivre des lois probabilistes connues de chacun, et chaque agent est supposé maximiser la mesure de son « bonheur » (ou son profit) en anticipant exactement la moyenne (l’espérance probabiliste) de ces variables aléatoires. ». Les agents économiques sont donc capables d’anticiper les conséquences des politiques économiques initiées par les États. L’économiste américain Robert Lucas a développé cette idée en affirmant que les agents ajustaient immédiatement leurs comportements aux politiques économiques, en anticipant parfaitement leur impact sur les variations de monnaie et de prix.19

Cette théorie est évidemment complètement fausse. Les citoyens et les entreprises ont, bien sûr, des capacités d’anticipation, mais elles sont beaucoup plus limitées que celles que leur prête la théorie. Celle-ci a cependant joué un rôle important dans la critique des politiques publiques et de la capacité des États à intervenir utilement dans l’économie, comme en témoignent par exemple Olivier Blanchard et Daniel Cohen, pour qui la théorie des anticipations rationnelles est considérée par « la plupart des macro économistes comme la meilleure hypothèse possible pour évaluer une mesure de politique économique ».20

Pour une formalisation mathématique de cette théorie, voir l’article de Gabriel Desgrange Équilibres et anticipations, 2017.

Ces hypothèses étant empiriquement non fondées, les conclusions sont pour le moins discutables. Dans tous les cas, elles ne peuvent être considérées comme le résultat d’une démonstration.

À la suite de ces travaux, des études empiriques ont cherché à mettre en évidence des comportements de ménage dits « ricardiens » (c’est-à-dire faisant l’arbitrage consommation-épargne que Robert Barro prête à tous les agents). Elles ne permettent pas de tirer de conclusions claires, ce qui revient à dire que, dans sa généralité, l’hypothèse selon laquelle les ménages sont ricardiens n’est pas fondée.

De nombreuses études s’intéressent à la question de l’effet des dépenses publiques et de la validation du multiplicateur budgétaire. Leur conclusions confirment l’existence de ce mécanisme, les controverses portant sur son évaluation quantitative et les conditions qui le rendent plus faibles ou plus élevés.

Pour en savoir plus, consultez les pages sur l’équivalence ricardienne de Wikipédia et du site Melchior.

Le « principe » d’invariance (ou de neutralité monétaire) de Sargent et Wallace

Selon les économistes américains Thomas Sargent et Neil Wallace, la politique monétaire ne peut pas être efficace à court terme. Leur papier « démonstratif », publié en 197521, s’appuie sur un modèle mathématique et repose sur l’idée qu’une « politique monétaire, dès lors qu’elle est systématique et cohérente, serait anticipée par les agents économiques22, ce qui en neutraliserait les effets. Il n’y aurait donc pas d’effet réel sur l’économie, seulement un effet sur les valeurs nominales ».23 Cela veut dire que les prix peuvent changer mais pas les quantités échangées.

La neutralité monétaire a été adoptée, dans les années 1970, par les banques centrales comme un principe cardinal. Elle est l’un des fondements des traités européens qui ont défini le mandat principal de la banque centrale comme étant la lutte contre l’inflation. D’après le principe d’invariance, la création monétaire est supposée n’avoir pas d’effet sur l’économie réelle, mais uniquement sur les prix. Du coup, elle perturberait le bon fonctionnement des marchés et en particulier la bonne allocation de l’épargne.

Comme l’équivalence ricardienne, ce principe repose sur la théorie des anticipations rationnelles, qui est éminemment discutable et sans fondement empirique. Mais il repose aussi sur un dogme et une double croyance. Le dogme est le dogme monétariste selon lequel l’inflation est exclusivement d’origine monétaire, et que l’accroissement de la masse monétaire se traduirait toujours par de l’inflation. La croyance est double : c’est la croyance de ces économistes en ce dogme et dans l’idée que ce dogme serait partagé par les citoyens. À leurs yeux, si les citoyens sont supposés rationnels, ils sont supposés partager la théorie adoptée par ces économistes….

Sans rentrer dans d’autres considérations analytiques, il n’est pas difficile de donner des exemples de cas où la politique monétaire a été tout sauf neutre.

Citons la politique monétaire (et le célèbre circuit du Trésor) en France pendant la Reconstruction24, les opérations de quantitative easing dans les années 2010, et à l’inverse les périodes de déflation, comme l’Allemagne de Brüning, ou la crise de 1929, où le défaut d’intervention des autorités monétaires a alimenté les crises.

Pour en savoir plus sur ce sujet, consultez le module sur La monnaie ainsi que la fiche Inflation et monnaie sur The Other Economy.

Le « théorème » d’Haavelmo

L’économiste norvégien Haavelmo (un keynésien) a cherché à démontrer dans un article publié en 194525 qu’une augmentation des dépenses publiques entièrement financées par une augmentation de l’impôt relancerait l’activité économique. La démonstration est très simple (voir encadré ci-après) et repose sur l’hypothèse que le multiplicateur de dépenses publiques (ratio de la hausse du PIB sur la hausse des dépenses) est supérieur au multiplicateur fiscal (ratio de la hausse du PIB sur la baisse des impôts).

Cette hypothèse est justifiée ainsi : l’augmentation des dépenses publiques peut élever d’autant la demande globale tandis que la hausse de l’impôt ne réduit la demande que pour la part de ce prélèvement supplémentaire qui n’aurait pas été épargnée. En d’autres termes, les dépenses publiques seraient entièrement transformées en revenus, alors que les réductions d’impôt peuvent être épargnées, sans effet sur l’activité.

Cette démonstration est cependant contestable du fait de plusieurs simplifications.

- Le raisonnement est en économie fermée, l’ouverture des frontières crée des « fuites » d’activité et un éventuel accroissement du déficit commercial.

- Le paramètre central du modèle, la propension marginale à consommer, est très difficile à connaître et ne peut être évaluée que via des modèles et des tests économétriques.26

- Une hausse de l’imposition peut avoir des effets négatifs sur l’activité économique en réduisant le rendement de l’investissement ou celui du travail, avec en conséquence une baisse de la demande et/ou de l’offre de travail.

Une étude empirique faite sur 200 expériences de « consolidations » réalisées dans 16 pays sur la période 1970-201427 montre que les « consolidations » engagées via une baisse des dépenses ont, pour un même rendement fiscal, des effets défavorables sur l’activité nettement plus faibles que celles engagées via une hausse de l’impôt.

En résumé, si Haavelmo pointe du doigt un argument important dans la conduite des politiques budgétaires et fiscales, il est exagéré d’employer le terme de théorème qui pourrait donner un caractère de vérité mathématique à un sujet qui se discute.

La démonstration du théorème d’Haavelmo

Partons d’un budget à l’équilibre, G = T (G = dépenses, T = prélèvements).

L’État décide d’augmenter son budget, tout en restant à l’équilibre : G + ΔG = T + ΔT, et donc ΔG = ΔT.

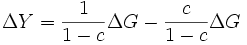

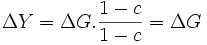

Par définition, l’évolution de la production Y (le PIB ) est ΔY = kG.ΔG + kT.ΔT, où kG et kT sont le multiplicateur de dépenses publiques et le multiplicateur de prélèvements, respectivement.

Comme kG = 1 / (1 − c) et kT = − c / (1 − c), (c =propension marginale à consommer),

on a donc :

soit :

Ce qui veut dire que la hausse des dépenses publiques a entraîné une hausse du PIB du même montant.

Le « théorème » du cost-share évaluant le poids de l’énergie dans le PIB

Enseigné dans tous les cours de microéconomie, le théorème du cost-share est important car il donne à penser que la sensibilité (dit autrement la dépendance) du PIB à un facteur de production serait égale à la part du PIB affectée à ce facteur de production.

Ainsi, comme l’énergie représente une très faible part du PIB, ce dernier en serait peu dépendant. C’est évidemment faux pour l’énergie, et encore de manière plus évidente pour l’eau ou l’alimentation. Les pénuries d’énergie, d’eau ou de nourriture ont des conséquences sociales et économiques considérables qui se répercutent sur l’ensemble de l’économie bien au-delà de la part de ces secteurs économiques telle que comptée dans le PIB.

De manière plus rigoureuse, selon le théorème du cost-share, il y a égalité entre la part de la rémunération d’un facteur de production28 dans le coût de production et l’élasticité29 de la production à ce facteur. Par exemple, si l’élasticité de la production au « facteur travail » est de 0,6 (une hausse de la quantité de travail de 100 fait croître la production de 60), la rémunération de ce facteur doit être de 60 % du coût de production. On peut dire aussi que la rémunération d’un facteur de production est égale à sa « productivité marginale ».

Le raisonnement peut être fait dans l’autre sens. Si la rémunération d’un facteur de production est de X% de la production alors la production est élastique à ce facteur à un taux de X%. L’idée sous-jacente intuitive c’est que si un des facteurs est rémunéré plus fortement qu’un autre, c’est que ce facteur est un contributeur relativement plus important de la production.

C’est ainsi que les économistes appliquant ce « théorème » en déduisent que la variation de la production d’énergie a peu d’impact sur le PIB car sa part de rémunération dans le PIB (de l’ordre de 10% maximum) est faible.

Pour en savoir plus

- Fiche Peut-il y avoir croissance sans énergie ? sur The Other Economy

- Vidéo Croissance & énergie : l’erreur des économistes ? sur la chaîne Youtube d’Eu?reka

- Gaël Giraud, Zeynep Kahraman, How Dependent is Growth from Primary Energy? The Dependency ratio of Energy in 33 Countries (1970-2011), 2014.

La « loi » d’Okun sur le lien entre croissance du PIB et du chômage

Que la croissance du PIB soit un moteur de l’emploi est l’une des croyances les plus partagées chez les économistes. On doit à l’économiste américain Arthur Okun la formulation de cette croyance sous forme d’une « loi » dans un article en 1962 et un livre en 1970.30

Cette loi n’a pas de fondement théorique31 et se contente de décrire une relation linéaire empirique entre le taux de croissance du PIB, et la variation du taux de chômage.

En toute rigueur, dire que la hausse du PIB permet de réduire le taux de chômage n’a pas de sens : le PIB est un concept tout comme le taux de chômage. Par ailleurs, le PIB comme le taux de chômage sont des notions largement conventionnelles.32 Un bas taux de chômage, par exemple, n’est pas synonyme de plein emploi.33 Enfin, sur le plan empirique, ce qu’on peut mettre éventuellement en évidence, ce sont des corrélations et en aucun cas des liens de causalité.

Cette « loi » s’écrit de manière très simple : Y = c U + d , (Y le PIB ; U le taux de chômage, c et d des coefficients à déterminer).

On peut l’écrire aussi de la manière suivante, et c’est la manière dont Okun l’a présentée :

ΔUt = β x (PIBt-PIBt*), pour une année t, où ΔUt est la variation du taux de chômage, PIBt le taux de croissance du PIB, PIBt* le seuil de croissance économique au-dessus duquel le taux de chômage baisse et β le « coefficient d’Okun » (β < 0, c’est l’élasticité du chômage au PIB).

Sur la période observée, Okun a trouvé pour les États-Unis un taux β de -0,3, ce qui veut dire qu’une baisse du chômage de 1% correspond à une hausse de PIB de 3%. Cette loi est donc utilisable en pratique de deux manières : elle permet de se dire quel est le taux de croissance minimal pour que la croissance « crée » de l’emploi et, si ce plancher est dépassé, quel impact sur l’emploi elle aura.

De nombreuses études économétriques ont été réalisées pour valider cette loi et déterminer le coefficient d’Okun. Elles montrent que ce coefficient varie selon les pays et les périodes. Par exemple, selon une étude du FMI34 parue en 2013, il varie entre -0,25 et -0,55. Dans sa thèse de doctorat35, l’économiste Gaëtan Stephan a réalisé une méta-analyse portant sur 28 articles sur la loi d’Okun publiés entre 1989 et 2009. Il a dénombré 269 coefficients d’Okun variant entre -3,22 et 0,17. Pour la France, une étude36 faite sur la période 1963-1978 l’a évalué à -0,2.

Enfin, cette loi ne dit rien sur les mécanismes en cause (qui stimulent la croissance ou le taux d’emploi) pas plus que sur la nature des emplois créés.

Qu’en conclure ? Que cette « loi » n’en est pas une bien sûr, au sens de ce terme en physique. Elle peut donner, pour un pays donné et une année donnée, une sorte d’estimation « au doigt mouillé » permettant, au mieux, de contrôler des estimations plus élaborées faites à partir de gros modèles économiques : quelle pourrait être la variation du chômage l’année prochaine si le PIB varie de telle manière ? Elle ne permet par contre en aucun cas d’avoir une règle valable sur le long terme et dans n’importe quel pays.

La « loi » de Phillips sur le lien entre chômage et inflation

L’économiste Alban W. Phillips publie en 1958 un article37 dans lequel il met en évidence une relation inverse entre le taux d’évolution des salaires nominaux et le taux de chômage au Royaume-Uni sur la période 1861-1957 : plus le taux de chômage est important, plus l’augmentation des salaires est faible.

Le raisonnement sous-jacent est assez intuitif : si le chômage est élevé, les travailleurs sont prêts à accepter des emplois moins bien rémunérés par peur du chômage. Inversement, en période de faible chômage, ils disposent d’un rapport de force favorable pour négocier leurs salaires à la hausse.

Cette courbe est plus connue sous une forme un peu différente : celle du lien entre chômage et inflation. Le chômage et l’inflation seraient corrélés négativement.

Deux justifications la sous-tendent :

- le coût du travail étant en général le coût de production le plus important des entreprises, toute augmentation de ce coût peut se répercuter sur les prix de vente ;

- les économistes considèrent que le taux de chômage constitue un indicateur de l’état de la demande globale dans l’économie (ceci est lié à la loi d’Okun). Plus le chômage est faible, plus on peut penser que l’économie est en « bonne santé » et que la demande de biens de consommation et de biens de production (l’investissement) est relativement élevée. Cette forte demande peut créer des pressions inflationnistes si l’offre n’arrive pas à suivre.

La « courbe de Phillips » est l’observation d’une corrélation, qui s’est révélée en fait très fluctuante selon les pays et les périodes, entre deux indicateurs (le taux de chômage et l’inflation) dont la construction repose sur des conventions. Par exemple, comme déjà dit pour la loi d’Okun, un faible taux de chômage n’est pas nécessairement un indicateur de plein emploi.

Au-delà du travail statistique et de ces limites, on peut dire un mot de l’enjeu théorique que pose cette courbe. Selon les keynésiens plutôt partisans de l’existence de cette corrélation, les salaires ne résultent pas d’une loi (qui les égaliserait à la productivité marginale du travail). Ils voient dans la courbe de Phillips une matérialisation de la détermination des salaires, qui passe par un rapport de forces : les salaires sont liés aux tensions qui existent sur le marché du travail, et aux enjeux de répartition entre salaires, profits et prix. Il est difficile de ne pas leur donner raison, ce qui n’empêche pas de discuter de l’existence d’une « loi » mathématique fixant la corrélation entre taux de chômage et niveau de salaires.

Pour en savoir plus voir la fiche La courbe de Phillips : le lien entre chômage et inflation sur The Other Economy.

Le « théorème » des avantages comparés de Ricardo

On doit à David Ricardo un argument en faveur du commerce international, connu sous le nom de théorème des avantages comparatifs, par opposition à celui des « avantages absolus » formulé par Adam Smith quelques décennies plus tôt.

En termes simples, selon ce « théorème », tout pays gagnerait à se spécialiser dans la production des biens pour lesquels son avantage comparatif est le plus élevé, c’est-à-dire dont les coûts relatifs sont les plus bas, et à acheter à l’étranger les biens qu’il ne produit pas. C’est donc un argument pour le libre-échange : tous les pays pourraient gagner du libre-échange en se spécialisant.

Ce théorème est en général « démontré » en représentant l’économie de manière ultra simplifiée, via un modèle mathématique basique, comme l’avait fait Ricardo : deux pays produisent chacun les deux mêmes biens ; les seuls coûts sont ceux de la main d’œuvre (il est donc sous-entendu qu’il n’y a pas de limite à la disponibilité des matières premières) ; de nombreux éléments de la vie réel sont absents (pas d’impacts en termes de pollutions et de déchets, il n’y a ni fiscalité, ni transport, ni monnaie ni crédit etc.)

Ce « modèle » n’a à l’évidence pas la capacité à représenter l’économie réelle dans sa complexité. Il ne peut donc être déduit de ce théorème aucune conclusion générale comme, par exemple, la supériorité du libre-échange sur le protectionnisme dans le monde réel. La littérature théorique ultérieure a, bien entendu, cherché à complexifier ce très frustre modèle initial sans néanmoins permettre de conclure38, tant la réalité en la matière ne se laisse pas enfermer dans une représentation mathématique.

La « loi » des rendements décroissants

La théorie de l’équilibre général repose sur plusieurs hypothèses, dont celle des rendements décroissants39 des facteurs de production que sont le travail et le capital.

Pour le travail par exemple, l’idée est qu’il existe un point au-delà duquel augmenter le nombre d’heures de travail à nombre de machines constant n’augmente pas proportionnellement la production. Le coût de la dernière unité produite est supérieur à celui des précédentes. Autrement dit, la rentabilité de cette dernière unité est inférieure à celle des précédentes. Cette hypothèse est généralement adoptée dans les modélisations économiques (celles utilisées pour la démonstration de l’équilibre général mais aussi dans la représentation habituelle des fonctions de production).40

Dans les faits, une situation de rendements croissants peut être observée dans de nombreux secteurs. Nous ne citerons ici que le cas de l’informatique et notamment l’industrie du logiciel où les rendements sont croissants.41 Ce sont des industries à coût fixe et à coût marginal nul : la dernière copie d’un logiciel ne coûte rien. Le coût principal est celui de la constitution de l’équipe, de ses frais de fonctionnement et du développement du logiciel, qui sont des coûts fixes. Dans cette situation, l’entreprise ne vend pas en fonction du prix de revient de l’unité vendue (avec une marge éventuelle) mais a toujours intérêt à vendre le maximum de produits tout en évitant un effondrement du prix.

En conclusion, l’hypothèse de rendements décroissants est plus que discutable. Et l’observation plutôt générale de la croissance des rendements est une des causes évidentes de l’existence d’oligopoles et du fait que la concurrence, au lieu de conduire à un foisonnement d’entreprises, conduit à la concentration de beaucoup d’entre elles dans nombre de secteurs.

Pour en savoir plus voir la Partie 2.3.4 dans l’Essentiel L’Équilibre des marchés : un mythe à la vie dure malgré les faits du module Marché, prix et concurrence.

- « Astronomes et géologues, pour ne citer qu’eux, ne font pas non plus d’expériences. Ils se servent des résultats obtenus par les sciences qui en font mais, surtout, accordent une place essentielle à l’observation. La régularité des phénomènes physiques, leur répétition, leur caractère universel (dans le temps et l’espace, du moins à une certaine échelle), permettent d’expliquer bon nombre de phénomènes (en géologie), et même de faire des prédictions de grande qualité (en astronomie). » Bernard Guerrien, L’économie, une science trop humaine ?, Encyclopedia Universalis, 2004. ↩︎

- Il existe bien des expériences en laboratoire (c’est l’économie comportementale) mais elles ne peuvent pas tester des théories macroéconomiques, qui doivent rendre compte de multiples interactions. Quant à l’économie « expérimentale », elle ne peut permettre de tirer de généralisations à partir d’études de terrain, même bien menées avec des groupes témoins. ↩︎

- C’est-à-dire en excluant toutes les autres causes potentielles. ↩︎

- Sous réserve que rien ne vienne perturber la formation des prix (par exemple : des taxes, la fixation réglementaire des prix comme celui de la baguette en France jusqu’en 1986 (voir Le vrai du faux de France Info du 01/02/2022), l’entente entre producteurs pour proposer un prix unique). ↩︎

- C’est Léon Walras qui, le premier, a formulé la théorie de l’équilibre général dans son ouvrage Éléments d’économie politique pure, 1874. ↩︎

- L’article de Wikipedia sur l’équilibre général propose une présentation synthétique du modèle de Arrow et Debreu. ↩︎

- Cela concerne également les « biens conditionnels », ce qui montre l’irréalisme de cette hypothèse. Un bien conditionnel est un bien qui sera livré à l’avenir, à la condition qu’un certain état futur se réalise. Un parapluie livré uniquement s’il pleut demain est différent d’un parapluie livré uniquement s’il fait beau demain. ↩︎

- L’économie néoclassique est un courant de pensée fondé à la fin 19e siècle par les économistes Léon Walras, William Stanley Jevons, Carl Menger, Alfred Marshall. Elle est largement dominante dans la pensée économique contemporaine et repose sur plusieurs concepts clés : la rationalité des agents économiques, le place centrale des marchés, le rôle des prix pour faire converger l’offre et la demande, l’individualisme méthodologique. Pour en savoir plus voir l’encadré dans le module « marché, prix et concurrence ». ↩︎

- Au sujet du Nobel d’économie, voir Pourquoi le « Nobel d’économie » n’est pas un prix Nobel comme les autres, Anne-Aël Durand, Le Monde (09/10/2023). ↩︎

- Voir son livre Irrational exuberance, Robert J. Schiller, Princeton University Press, 2000, (dernière édition 2016) ; Version française publiée chez Valor Éditions ; voir aussi Marie-Pierre Dargnies et al., Robert J. Shiller – L’exubérance irrationnelle des marchés, dans Les Grands Auteurs en Finance, EMS Editions, 2017. ↩︎

- Voir par exemple Michel Albouy, Peut-on encore croire à l’efficience des marchés financiers ?, Revue française de gestion, 2005 ; Bernard Guerrien, L’imbroglio de la théorie dite « des marchés efficients » (téléchargement en .doc), 2011 ; Gaël Giraud, Illusion financière, Éditions de l’Atelier, 2014. ↩︎

- Robert J. Barro, Are Government Bonds Net Wealth? Journal of Political Economy, 1974. ↩︎

- Barro on the Ricardian Equivalence Theorem, Journal of Political Economy, 1976. ↩︎

- Le multiplicateur budgétaire désigne le rapport entre la variation du revenu national (le PIB) et la variation des dépenses publiques. S’il est supérieur à 1, cela signifie que tout euro de dépense publique supplémentaire génère plus de 1 euro d’activité économique globale supplémentaire. Pour en savoir plus voir la fiche Le multiplicateur de dépenses publiques. ↩︎

- John Maynard Keynes (1883-1946) est un économiste anglais reconnu, qui a remis en cause la vision classique de l’économie selon laquelle les marchés sont autorégulés. Il a publié en 1936 un livre qui a révolutionné la façon de comprendre l’économie : la Théorie générale de l’emploi, de l’intérêt et de la monnaie. ↩︎

- Ce qui veut dire, en termes simples, que le salaire de chaque travailleur est fixé en fonction de l’augmentation de la production que ce travailleur va pouvoir apporter. ↩︎

- John F. Muth, Rational Expectations and the Theory of Price Movements, Econometrica, 1961. ↩︎

- Billet de blog de Gaël Giraud sur Médiapart Crise de la « science économique » 2/2 ? (01/12/2015). ↩︎

- Robert Jr Lucas, Expectations and the neutrality of money, Journal of Economic Theory, 1972. ↩︎

- Olivier Blanchard, Daniel Cohen, Macroéconomie, 8e édition, Pearson, 2020. ↩︎

- Thomas J. Sargent, Neil Wallace, Rational expectations, the optimal monetary instrument and the optimal money supply role, Journal of Political Economy, 1975. ↩︎

- En application de la théorie des anticipations rationnelles – voir l’encadré dans la partie sur l’équivalence ricardienne. ↩︎

- Comme le formule par exemple le site MisterPrépa dans un article intitulé « Quelques lois et théorèmes économiques incontournables », qui ne questionne aucune de ces « lois », et fournit un excellent exemple du discours économique dominant. ↩︎

- Voir le livre de Benjamin Lemoine , L’ordre de la dette, La Découverte, 2016 et la thèse d’Éric Monnet, Politique monétaire et politique de crédit pendant les Trente glorieuses, 1945-1973, EHESS, 2012. ↩︎

- Trygve Haavelmo, Multiplier Effects of a Balanced Budget, Econometrica, 1945. ↩︎

- Voir par exemple pour la France l’étude Consommation et patrimoine des ménages : au-delà du débat macroéconomique… de l’INSEE (2014). ↩︎

- Alberto Alesina, Carlo Favero et Francesco Giavazzi, Austerity: When It Works and When It Doesn’t, Princeton University Press, 2019. Ce livre examine notamment les politiques d’austérité mises en œuvre dans différents pays européens au début des années 2010 à l’occasion de la crise de l’euro. ↩︎

- En simplifiant, le travail est un facteur de production rémunéré par le salaire, le capital est un facteur de production rémunéré par les dividendes. ↩︎

- L’élasticité est un terme économique qui désigne l’évolution d’une grandeur en réponse à une petite variation d’une autre. Par exemple, une élasticité prix-demande de -10% pour un produit signifie que si le prix de ce produit augmente de manière modérée – disons de 5%, la demande de ce produit baissera de 0,5% (-10% * 5% = -0,5%). ↩︎

- rthur M. Okun, Potential GNP: Its measurement and significance, American Statistical Association, Proceedings of the Business and Economics Section, 1962 et The Economics of Prosperity, Brookings Institution, 1970. ↩︎

- Même si elle a fait l’objet de démonstrations mathématiques, bien après les travaux d’Okun. Voir par exemple Adama Zerbo, Croissance économique et chômage : les fondements de la Loi d’Okun et le modèle IS-LM-LO, Groupe d’économie du développement de l’Université de Bordeaux, 2017. ↩︎

- Voir l’Essentiel Le calcul du PIB repose sur de nombreuses conventions dans le module PIB, croissance et limites planétaires et l’Essentiel Pour caractériser le sous-emploi, le taux de chômage est un indicateur discutable, dans le module Travail et chômage. ↩︎

- Le taux de chômage est le pourcentage de chômeurs dans la population active. Pour estimer le nombre de chômeurs, les instituts statistiques se fondent sur les critères du Bureau international du travail : un chômeur est une personne en âge de travailler (15 ans ou plus) qui 1/ n’a pas travaillé au cours de la semaine de référence 2/ est disponible dans les 15 jours et 3/ a entrepris des démarches de recherche d’emploi dans le mois précédent. Le taux de chômage n’inclut donc pas les chômeurs découragés ou les personnes non disponibles dans les 15 jours (stage, formation, maladie). Par ailleurs, il ne tient pas compte du sous-emploi, c’est-à-dire des personnes en temps partiel souhaitant travailler. Pour en savoir plus voir l’Essentiel Pour caractériser le sous-emploi, le taux de chômage est un indicateur discutable, dans le module Travail et chômage. ↩︎

- Laurence Ball, Daniel Leigh, and Prakash Loungani, Okun’s law : fit at 50 ?, IMF Working Paper, 2013. ↩︎

- Gaëtan Stephan, La déformation de la loi d’Okun au cours du cycle économique, Université de Rennes, 2014. ↩︎

- Olivier Favereau et Michel Mouillart, La stabilité du lien emploi-croissance et la loi d’Okun : une application à l’économie française, Consommation-Revue de Socio-Économie, 1981. ↩︎

- Alban W. Phillips, The Relation between Unemployment and the Rate of Change of Money Wage Rates in the United Kingdom, 1861–1957, Economica, 1958. ↩︎

- Voir sur ce sujet Gaël Giraud, L’épouvantail du protectionnisme, Revue Projet, 2011. ↩︎

- Historiquement, cette loi est due à David Ricardo qui la tenait pour vérifiée dans le monde agricole et pour le facteur de production qu’est la terre. Voir la page Loi des rendements décroissants de Wikipédia. ↩︎

- Une fonction de production de type Y= f (K, L) (où K est le capital et L le travail ) est à rendement décroissant pour un facteur de production si sa dérivée seconde par rapport à ce facteur est négative. C’est le cas des fonctions Cobb-Douglas utilisées généralement, de type Y= c *Ka*Lb. où a+b = 1. Les rendements d’échelle concernent l’ensemble des facteurs de production et pas juste l’un d’entre eux. ↩︎

- Voir le livre de Michel Volle, L’iconomie , Economica, 2014. ↩︎