Comprendre le mécanisme de l'actualisation

L’actualisation est la technique qui permet de ramener les valeurs reçues (ou dépensées) à différents instants du temps à une valeur présente. Elle permet de comparer des sommes monétaires aujourd’hui avec des sommes dans le futur.

1.2 Perception intuitive de ce qu’est l’actualisation

Commençons par une question simple : à revenu et niveau de prix constants, préférez-vous recevoir 100 € aujourd’hui ou 101 € dans un an ? Vous répondrez sûrement 100 € aujourd’hui, soit par impatience à toucher cet argent, soit par nécessité immédiate, soit pour en profiter de façon certaine, car qui sait de quoi demain sera fait ?

Reformulons cette question différemment. Au lieu de vous interroger sur votre préférence entre une somme d’argent perçue aujourd’hui ou plus tard, demandez-vous à partir de quelle somme perçue dans un an vous seriez prêts à renoncer à recevoir 100 € aujourd’hui.

Votre réponse se situera probablement entre 100 et 110 €, peut-être au-dessus pour certains.

Traduit en termes économiques, vous venez d’actualiser la somme que vous comptez recevoir dans le futur, c'est-à-dire de la ramener à la valeur qu’elle représente pour vous aujourd’hui.

1.2 Le taux d’actualisation est en quelque sorte l’inverse du taux d’intérêt

Si vous placez 100€ sur un livret rémunéré, vous récupérerez dans le futur la somme initiale plus un certain multiple, fonction du taux d’intérêt du placement.

Actualiser une somme, c’est considérer cette opération mais dans l’autre sens, à rebours du temps : que représentent des flux perçus dans le futur en valeur d’aujourd’hui ?

Comprendre le calcul du taux d'actualisation

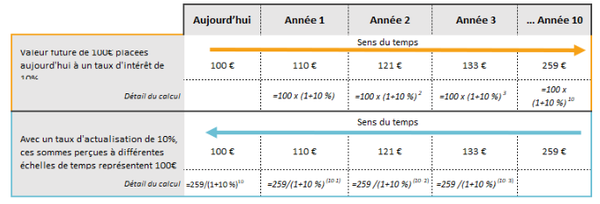

Le taux d’intérêt permet de déterminer la valeur future d’un montant présent : 100€ placés à 10% vaudront 110€ dans un an et 259€ dans 10 ans.

Le taux d’actualisation permet de faire le raisonnement inverse : avec un taux d’actualisation de 10% par an, 110 € perçus dans un an ont une valeur actuelle de 100 €. De même que 259€ reçus dans dix ans.

Point d’attention: les raisonnements précédents sont effectués dans un cadre où il n’y a pas d’inflation. C’est en général le cadre dans lequel raisonnent les économistes. Les niveaux de revenus indiqués dans le tableau sont calculés en prenant pour base le niveau des prix de l’année de départ.

1.3 Un taux d’actualisation élevé « écrase » le futur

Notons tout de suite un point fondamental : plus le taux d’actualisation est élevé moins la valeur actuelle des montants futurs est importante.

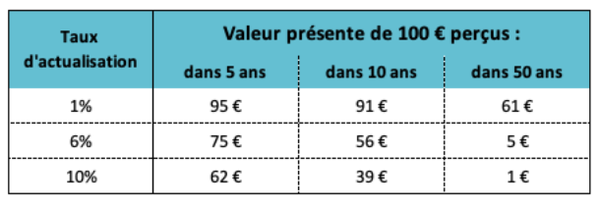

Valeur actuelle de 100€ futurs selon différents taux d'actualisation

Comme on le voit sur ce tableau, avec un taux d’actualisation de 10%, 100€ reçus dans 50 ans “valent” 1€ aujourd’hui. Avec un taux d’actualisation de 1%, ces mêmes futurs 100€ valent aujourd’hui 61€.

Comme on va le voir dans les parties suivantes, le taux d’actualisation est déterminant pour décider ou non d’investir que ce soit dans le domaine privé ou public. En résumé, il permet de déterminer combien on est prêt à investir aujourd’hui pour toucher un montant demain.

Dans le tableau ci-dessus, un investisseur est prêt à apporter aujourd’hui 61€ à un projet qui lui rapportera 100€ dans 50 ans avec un taux d’actualisation de 1%, mais seulement 5€ dans avec un taux de 6%.

Retenons pour l’instant que plus le taux d’actualisation est élevé, moins le futur compte dans les calculs réalisés aujourd’hui.

C’est important en matière de typologie d’investissement : avec un taux d’actualisation élevé, un projet qui permet de dégager des revenus à court terme paraîtra nettement plus intéressant que celui qui les génère à plus long terme.

C’est également important en matière écologique. D’une part les projets écologiques ont souvent des « rendements » à long terme. D’autre part, de très nombreux projets génèrent des coûts au moment de leur fin de vie fiche2 (démantèlement d’une usine, d’une centrale nucléaire ou à charbon, dépollution des sols, remise en état d’un site minier etc.). Avec un taux d’actualisation élevé, ces dépenses qui interviendront dans le futur (souvent plusieurs décennies) comptent très peu dans les calculs initiaux visant à évaluer la rentabilité de l’investissement pour décider de le réaliser ou non.

Nous allons maintenant entrer davantage dans le détail de différents types d’acteurs qui ont recours à l’actualisation pour faire des calculs économiques.

Le taux d’actualisation : une donnée fondamentale dans les investissements privés

Une entreprise qui cherche à renouveler ses équipements ou à développer de nouvelles activités a besoin d’investir. Afin de savoir si cet investissement est opportun financièrement, les dirigeants de l’entreprise vont en calculer le rendement et ont pour cela recours à un calcul d’actualisation. Un acteur financier qui hésite entre deux types d’investissements (par exemple investir dans le capital d’une entreprise industrielle ou dans un projet immobilier) agira de même.

2.1 Le taux de rendement interne (TRI) est le taux d’actualisation utilisé pour évaluer la rentabilité d’un investissement

L’une des méthodes fréquemment utilisées pour évaluer le rendement d’un investissement consiste à comparer le coût de l’investissement initial à la valeur présente (c'est-à-dire la valeur actualisée) de tous les flux de trésoreries futurs note1 qui seront générés par cet investissement sur sa durée de vie.

Pour cela, on utilise la valeur actuelle nette (VAN) qui compte en négatif le coût de l’investissement initial et en positif les flux de revenus futurs (une fois déduites les charges). Ces derniers intervenant à différentes échelles de temps, il est nécessaire de les actualiser. Mais comment déterminer le taux d’actualisation adéquat ?

Par convention, les investisseurs utilisent le taux de rendement interne (TRI) : c’est le taux d’actualisation qui permet de ramener la VAN à 0.

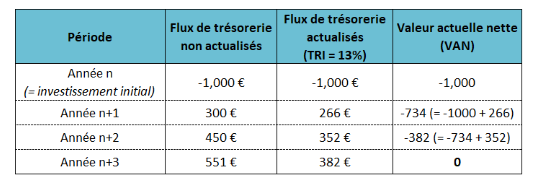

Prenons un exemple chiffré pour mieux comprendre.

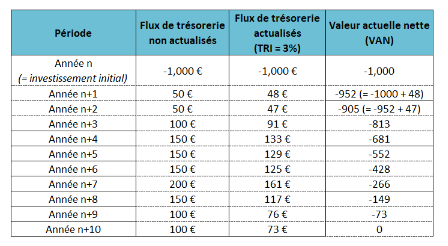

Exemple – VAN et TRI du projet d’investissement de l’entreprise The Mainstream Economy

L’entreprise The Mainstream Economy investit 1000€ pour acheter des machines d’une durée de vie de trois ans et estime en retirer les revenus ci-après.

Le Taux de rendement interne du projet, c'est-à-dire celui qui permet que les 1000€ de l’investissement initial soient compensés par les revenus futurs actualisés est de 13%.

2.2 Un investissement est considéré comme rentable financièrement à partir du moment où le TRI est supérieur au coût du financement (WACC en anglais)

Le coût du financement de l’entreprise (ou du projet) est calculé en fonction :

- de la structure financière de l’entreprise (ou du projet spécifique d’investissement) c'est-à-dire de la répartition entre les fonds propres (les capitaux) et les dettes ;

- des coûts respectifs des capitaux et de la dette.

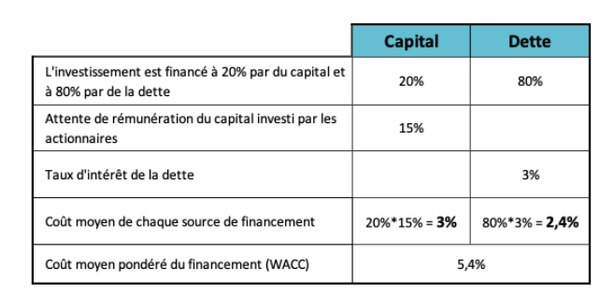

A noter que le terme communément utilisé n’est pas « coût du financement » mais « coût moyen pondéré du capital » note2 ce qui porte à confusion puisque le financement peut reposer sur du capital et de la dette.

Exemple de calcul du WACC du projet d’investissement de l’entreprise The Mainstream Economy

L’entreprise a financé son investissement avec 80% de dette (négocié à la banque à un taux d’intérêt de 3%) et 20% de capital (avec une attente de rémunération de 15%). Le WACC est donc de 5,4%, largement inférieur au TRI de 13% que nous avons vu plus haut. Le projet développé par The Mainstream Economy est donc très rentable !

Dans la pratique financière « normale » (enseignée dans les écoles de commerce) un investisseur financier devrait donc se donner comme objectif d’obtenir un TRI égal ou supérieur au coût moyen pondéré du capital, soit une VAN nulle ou positive.

Quand la VAN est positive on dit que l’entreprise ou le projet « crée de la valeur », ce qui est très discutable, car il ne s’agit en l’occurrence que des gains financiers des investisseurs.

Pour poursuivre notre exemple précédent, le projet d’investissement de The Mainstream Economy créera chaque année une « valeur » de 7,6% (13%-5,4%) multipliée par la taille de l’investissement.

Les exigences de rémunération des financeurs

Concernant la dette, le taux d’intérêt fait l’objet d’une négociation entre le prêteur (une banque, un investisseur obligataire) et les dirigeants de l’entreprise. Ces taux dépendent de différents éléments relatifs à la perception des risques par les prêteurs (situation financière de l’entreprise, secteur d’activité, positionnement concurrentiel, économie du projet lui-même), ainsi qu’au niveau général des taux d’intérêt. Ce dernier point est particulièrement important : les taux d’intérêt très bas de la décennie 2010 ont ainsi permis de contenir les coûts du financement de façon générale.

Concernant les investisseurs en capital, c'est-à-dire les actionnaires, on peut distinguer deux cas. Pour une entreprise cotée en bourse, le rendement attendu des capitaux propres (ROE note3) est en gros défini par « le marché » et par la situation concurrentielle de l’entreprise dans son secteur. Précisons ici que « le marché » n’est pas une entité abstraite mais un lieu de confrontation et de rapport de forces qui peuvent évoluer, à la fois du fait des pouvoirs relatifs des différents acteurs, et des dispositifs institutionnels. Le ROE s’est globalement accru depuis les années 1950, notamment du fait l’accélération de la « mondialisation » et de la financiarisation de l’économie dans les années 1980. Pour une entreprise non cotée, les actionnaires ont plus de latitude en matière de ROE.

En règle générale, les attentes des investisseurs en capital sont aussi élevées que possible : ayant de nombreux choix d’investissements, ils ciblent ceux qui promettent le plus de rentabilité. Par ailleurs, ces investisseurs sont souvent des intermédiaires qui gèrent l’épargne de clients auxquels ils ont promis une rémunération.

2.3. Le coût du financement, et donc les rendements attendus des financeurs, influent sur le type de projets, en désavantageant notamment les projets de long terme.

En effet, un WACC élevé implique d’avoir un TRI élevé également sinon le projet ne sera pas considéré comme rentable et ne trouvera donc pas de financements.

Or comme on l’a vu dans la partie 1, plus le taux d’actualisation (ici le TRI) est élevé, moins les revenus futurs comptent. Les projets qui génèrent des revenus sur le long terme sont donc désavantagés par rapport à ceux qui en promettent sur le court terme.

Par exemple, imaginons que l’entreprise The Other Economy (TOE) souhaite développer un projet dont le coût initial est également de 1000€ mais dont les revenus futurs sont plus faibles et plus étalés dans le temps que ceux de l’entreprise TME.

Exemple – VAN et TRI du projet d’investissement de l’entreprise The Other Economy

Le TRI est alors moindre (environ 3%). Avec le même coût de financement que le projet de The Mainstream Economy (5,4%), l’investissement est considéré comme non rentable et a peu de chance de trouver des financements privés.

C’est le cas pour nombre de projets de transition écologique, dont les bénéfices écologiques et sociaux ne sont généralement note4 pas valorisés dans les calculs financiers.

Prenons l’exemple d’une usine productrice d’acier, qui doit changer ses modes de production pour les rendre plus écologiques. Cela nécessite un lourd investissement, pour mettre en place les nouveaux procédés de l’usine. Le produit final reste le même, qui a simplement coûté plus cher à produire, en raison de l’investissement initial réalisé. Les consommateurs ne sont donc a priori pas disposés à débourser plus d’argent pour acheter ce nouvel acier. Si l’entreprise augmente trop le prix de son nouvel acier, les consommateurs se détourneront de l’entreprise, et elle ne gagnera donc pas assez d’argent pour rembourser l’investissement initial. Les bénéfices d’une telle opération sont plutôt faibles pour l’entreprise, alors qu’ils profitent à la société entière, via une baisse de la pollution (bénéfices écologiques et sociaux). Ces derniers ne sont pourtant pas pris en compte dans le calcul de l’entreprise.

Si les financiers perçoivent le projet comme risqué (par exemple parce qu’il s’agit d’un produit nouveau, et/ou dans un cadre réglementaire incertain), leurs attentes de rendement ne peuvent être satisfaites, et le projet ne se réalisera pas par manque de financement.

Pour lever cette difficulté (qui empêche certains des projets de la transition d’être financés) plusieurs solutions sont imaginables et mises en place en partie.

- le recours à du « capital patient », c'est-à-dire des investisseurs prêts à accepter des rendements moindres, ou à des financements publics. En tant qu’investisseurs en capital, l’État et les structures publiques n’ont pas les mêmes attentes de rendement financier que la plupart des investisseurs privés (pour les raisons développées dans la partie 3).

- améliorer la rentabilité opérationnelle du projet par des dispositifs publics (comme les aides et subventions publiques sous diverses formes, les tarifs de rachat, le paiement de services écosystémiques).

- réduire le coût de financement par des dispositifs publics (garanties, bonification de taux, financement partiel etc. )

Le taux d'actualisation est aussi une donnée publique commune

3.1 En tant qu’investisseur, l’État ne recherche par le même type de rentabilité qu’un acteur privé

L’État et les collectivités publiques investissent chaque année dans des projets de différents types : infrastructures, production énergétique, transports en commun, bâtiments publics etc. En 2021, d’après le ministère de l’Économie, les investissements publics se sont ainsi élevés à 89,7 milliards d’euros note5 soit 3,7 % du PIB français.

Ces investissements obéissent à des logiques de rentabilité différentes de celles de la sphère privée. Ils n’ont pas pour objectif premier de faire gagner de l’argent à l’État mais d’apporter des bénéfices économiques, sociaux ou écologiques à la collectivité. Et il est attendu qu’ils atteignent ces objectifs de la manière la moins « coûteuse » possible pour les contribuables.

Il s’agit alors de calculer le « rendement socioéconomique » des investissements publics. Pour cela un des outils utilisés est l’évaluation socio-économique, aussi appelée analyse coût-bénéfices (ACB).

L’ACB consiste à comparer dans un bilan monétarisé les coûts et les avantages d’un projet en intégrant les aspects financiers mais aussi les impacts non-marchands (gain de temps pour des usagers de transports, sécurité, accès au service public, réduction des pollutions, émissions de gaz à effet de serre...). Ces coûts et bénéfices s’étalant sur plusieurs années, ces calculs font intervenir un taux d’actualisation.

Par exemple, en France 40,4 % des projets à l’étude, recensés dans l’inventaire 2022 du Secrétariat Général pour l’Investissement, ont fait l’objet d’une ACB. Notons que ces évaluations ne sont pas réalisées pour tous les projets (il existe notamment des seuils financiers), sont complétées par d’autres types d’évaluation (par exemple des évaluations environnementales non monétarisées) et qu’elles n’ont pas valeur de décision (un résultat négatif ne conduit pas nécessairement à l’abandon d’un projet).

3.2 Le choix du taux d’actualisation retenu pour un projet d’investissement est un sujet très sensible

Nous verrons dans une autre fiche que l’ACB est en soi une méthode très discutable pour de nombreuses raisons. Ici, nous nous limitons à montrer le rôle clef du taux d’actualisation dans ces calculs.

Pour les investissements publics, le taux d’actualisation à appliquer aux projets est déterminé de façon conventionnelle par les pouvoirs publics à la suite de recommandations de commissions d’économistes.

Comme pour les investissements privés, son niveau a une influence de premier ordre sur le résultat de l’ACB de tout projet ayant une durée de vie de plusieurs décennies, ce qui est le cas de la plupart des projets d’infrastructure.

Prenons l’exemple d’une centrale nucléaire. Sa construction représente un investissement important pendant plusieurs années. Les bénéfices, issus de la vente d’électricité, arrivent ensuite. Ils sont plus modestes mais durent toute la vie de la centrale (plusieurs décennies). Dans ce type de projet l’ACB est très sensible au taux d’actualisation retenu. S’il est fort, les bénéfices comptent rapidement pour presque rien et le projet n’apparaît pas comme rentable. S’il est plus faible, la somme actualisée des bénéfices peut dépasser le coût initial : le projet considéré comme rentable peut être lancé. Enfin, si le taux d’actualisation est très faible, et que la fin de vie de la centrale induit des coûts importants (démantèlement, gestion des déchets sur le très long terme), il est possible que le projet soit de nouveau déclassé. Les choses se compliquent encore quand on ajoute les coûts et bénéfices non marchands (les émissions de CO2 évitées, les impacts environnementaux en termes de prélèvement d’eau ou de gestion des déchets etc.).

On comprend aisément comment le choix du taux d’actualisation peut susciter de multiples controverses : l’usage d’un taux élevé ou faible ayant un intérêt stratégique pour les détracteurs ou au contraire les promoteurs d’un projet.

Des controverses à ce sujet surgissent pour tous les types de grands projets : développements des voies d’eau aux États-Unis dans les années cinquante, construction des centrales nucléaires, conservation des ressources naturelles. Les économistes n’étant pas d’accord entre eux sur le choix du taux d’actualisation ni même sur une fourchette étroite raisonnable, des arguments sont perpétuellement soulevés dans un sens ou dans l’autre. La controverse sur les grands projets d’infrastructure devient une controverse sur l’actualisation, et celle-ci en retour nourrit la controverse sur le projet initial. Antonin Pottier.

3.3 La règle de Ramsey est l’une des principales méthodes utilisées par les économistes pour déterminer le taux d’actualisation

Vu son importance pour déterminer la rentabilité socio-économique d’un investissement public, le taux d’actualisation est une donnée publique dont la détermination est un enjeux politique.

Cela a largement dynamisé la recherche académique en la matière, comme le montrent Groom et Hepburn dans un article paru en 2017 note6 où ils mettent en lumière la double interaction positive entre intérêt politique pour l’actualisation et recherche académique en la matière. Leur étude se base sur des données au Royaume Uni, aux Etats-Unis, en France et aux Pays-Bas, entre 2002 et 2017.

Cet intérêt académique se double d’une portée très opérationnelle. En effet, comme nous allons le voir dans la partie suivante avec l’exemple de la France, le taux d’actualisation des projets d’investissement public est fixé par des commissions ayant mandat officiel pour ce faire. Celles-ci sont dirigées et/ou font appel à des économistes. Il est donc important de comprendre quelles méthodes ces derniers utilisent.

Nous allons ici décrire la règles de Ramsey qui est la plus communément utilisée. Dans la partie 4, nous verrons avec l'exemple du réchauffement climatique à quel point cette règle est critiquable.

La règle de Ramsey

Les économistes qui travaillent sur le taux d’actualisation adoptent généralement une approche théorique, différente de la pratique financière exposée dans la partie 2.

Elle consiste à raisonner du point de vue du consommateur, et à déterminer les conditions qui lui permettent de maximiser son utilité fiche3 (sa consommation) intertemporelle. Ils adoptent généralement une formule connue sous le nom de « règle de Ramsey » note7 qui décompose le taux d’actualisation en paramètres « éthiques » et « politiques ».

Dans sa version la plus simple, cette formule s’écrit ainsi : 𝑟 = p + n x 𝑔

Avec :

𝑟 = le taux d’actualisation

p = le taux de préférence pure pour le présent (aussi noté TPPP)

Ce terme traduit l’idée selon laquelle les individus préféreraient consommer aujourd’hui plutôt que demain soit pour des raisons psychologiques (impatience), soit du fait de l’incertitude concernant le futur (il existe une probabilité non nulle de mourir avant de percevoir le revenu futur).

n = l’aversion à l’inégalité temporelle (ou élasticité intertemporelle de consommation).

Ce terme traduit la préférence des individus à avoir une consommation « lisse » dans le temps. Par exemple, on peut préférer passer toute sa vie avec 2000€ par mois, plutôt qu’une première moitié avec 500€ et une deuxième avec 3500€. Plus ce terme est grand, plus il traduit une volonté de consommation (et donc de revenus) lisse dans le temps. S’il est faible, il traduit au contraire une tolérance à des consommations hétérogènes. En résumé, il accorde la priorité (plus ou moins forte) à la période la plus pauvre.

𝑔 : le taux de croissance attendu des revenus, (assimilable au taux de croissance du PIB)

Le paramètre n est multiplié par le taux de croissance. L’idée est la suivante : si j’ai plus de revenus dans le futur qu’aujourd’hui, j’aurais tendance à donner plus de poids à mes revenus présents (et ce d’autant plus que mon aversion à l’inégalité intertemporelle est forte). Inversement, si mes revenus décroissent, je donnerai davantage de poids aux revenus futurs. Notons que dans la formule de Ramsey, ce raisonnement est étendu à tous les agents économiques appréhendés de façon globale (il ne tient donc pas compte de l’inégale répartition de la croissance entre individus).

Introduction de la notion de risque dans la formule de Ramsey

Cette formule initiale a ensuite été complexifiée pour introduire une prime de risque. Sans entrer dans les équations (qui d’ailleurs peuvent varier selon les modèles retenus), retenons ici que la notion de risque est envisagée de façon assez limitée : il s’agit d’évaluer les risques que porte le projet lui-même (et non ceux qu’il permet d’éviter par exemple), en particulier sa dépendance à la croissance économique.

Prenons un exemple. On part du taux d’actualisation sans risque (formule de Ramsey) et on ajoute une prime de risque en fonction de la dépendance estimée du projet à la croissance économique future. Si cette prime est positive (ex : les trains sont moins fréquentés quand la croissance économique ralentit) le taux d’actualisation avec risque est plus élevé que le taux sans risque. Inversement si la prime de risque est négative (la fréquentation des hôpitaux est plus importante en cas de difficultés économiques) le taux d’actualisation avec risque est plus faible que le taux sans risque.

3.4 Que préconisent les rapports officiels sur le sujet en France ?

Comme expliqué dans la partie précédente, le choix du taux d’actualisation retenu pour les projets d’investissement public est un sujet très sensible.

En France, la doctrine administrative en la matière a été fixée par des commissions, mandatés par des organismes prospectifs rattachées au Premier Ministre note8. Elle a largement évolué ces dernières décennies.

Alors que le taux d’actualisation avait été fixé à 8% en 1985 par le Commissariat Général du Plan, et ce jusqu’au début des années 2000, le rapport Lebègue (2005) note9 a proposé de l’abaisser à 4% sur les 30 années suivant l’investissement dans un projet, puis de le faire décroître progressivement sur la fin de vie du projet jusqu’à la valeur minimale de 2%.

Il a été complété en 2011 par le rapport Gollier note10 qui propose l’introduction d’une prime de risque, venant augmenter le taux d’actualisation si le projet est exposé aux risques macro-économiques (comme une perte de croissance économique), et le diminuer dans le cas contraire. Cette idée a été précisée dans le rapport Quinet en 2013 note11.

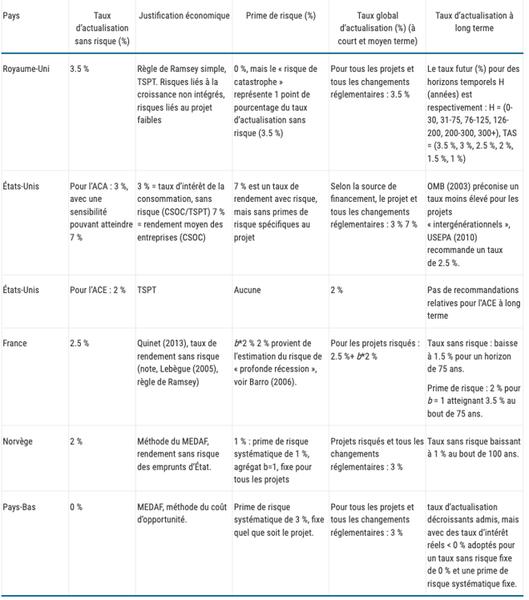

Avant 2021, le taux d’actualisation sans risque retenu en France était autour de 2,5%, se situant dans la moyenne des autres pays de l’OCDE. L’ouvrage Cost Benefit Analysis and the Environment, écrit par Atkinson, Braathen, Groom et Mourato, mandatés par l’OCDE résume, au chapitre 8, les principales approches des pays membres quant à l’actualisation.

Recommandations en matière d'actualisation dans plusieurs pays de l'OCDE

En 2021, un groupe d’experts travaillant pour France Stratégie note12 a proposé une nouvelle méthode de détermination du taux d’actualisation tenant compte des risques du projet (liés à sa dépendance à la croissance économique). Le taux sans risque est passé à 1,2%.

Comme nous l’avons vu, la détermination du taux d’actualisation a des impacts très concrets sur l’évaluation de la rentabilité des projets d’investissement publics. Or les méthodes utilisées, présentées comme scientifiques, souffrent de nombreuses insuffisances. C’est ce que nous allons voir dans la partie suivante en prenant l’exemple célèbre du réchauffement climatique.

Pour en savoir plus

Pour en savoir plus

Le taux d’actualisation et l’évaluation des impacts économiques à long terme du changement climatique

L’émergence de la problématique climatique a mené certains économistes à tenter d’évaluer les impacts que le réchauffement pourrait avoir à long terme sur le PIB fiche4. Les débats et controverses qui ont eu lieu permettent de mettre en évidence plusieurs éléments importants sur le taux d’actualisation :

- Comme déjà vu, selon le taux d’actualisation choisi, les impacts à long terme du dérèglement climatique auront plus ou moins de poids. C’est donc un paramètre déterminant pour les résultats de l’analyse et les recommandations qui en découlent.

- Ce choix implique nécessairement des réflexions éthiques et idéologiques. Il ne peut être laissé aux seuls débats techniques des économistes.

Cette partie reprend de nombreux éléments de l’analyse réalisée par Antonin Pottier dans son livre Comment les économistes réchauffent le climat.

4.1 L’usage du taux d’actualisation dans les calculs économiques relatifs à la lutte contre le changement climatique

En 2018, l’économiste William Nordhaus recevait le prix Nobel d’économie en récompense de « ses travaux précurseurs sur l’intégration du changement climatique dans l’analyse macroéconomique de long terme ». Il a en effet conçu, au début des années 1990, le modèle macroéconomique DICE fiche4 couplant un module de croissance de long terme et un module climatique.

L’objectif de Nordhaus est de déterminer, via ce modèle, la trajectoire d’émissions de gaz à effet de serre (et donc de réchauffement) « optimale » au niveau économique en vue de maximiser le « bien-être » intergénérationnel (assimilé à la consommation). Si le monde suit cette trajectoire, les coûts actuels de la lutte contre le réchauffement climatique seront compensés par les bénéfices futurs (c'est-à-dire les dommages évités). Il s’agit également d’en déduire des recommandations en termes de politiques publiques, et en particulier en matière de fixation d’un prix au CO2, principal (mais non le seul) gaz à effet de serre fiche5 responsable du réchauffement climatique note13.

Ce modèle réalise donc une analyse coût-bénéfice avec d’un côté les coûts engendrés par la mise en place de politiques de lutte contre le changement climatique (moyens de production électriques renouvelables et nucléaires, isolation des bâtiments, électrification des transports, mise en place de solutions de mobilité douce, transition agricole…), et de l’autre les bénéfices c’est à dire les dommages liés au dérèglement climatique que ces politiques permettront d’éviter.

Ce type de démarche pose de nombreux problèmes.

- L’objectif lui-même pose question : la lutte contre le dérèglement climatique a bien plus pour objet de préserver l’habitabilité de notre planète pour les êtres humains que la maximisation intertemporelle de la consommation.

- Le niveau des coûts des politiques climatiques (appelés coûts d’abattement) est lui aussi sujet à controverse (certaines de ces politiques vont créer de l’activité et ne sont donc pas des coûts au niveau macro-économique).

- Les dommages futurs du réchauffement climatique sont évidemment extrêmement difficiles (et, en toute rigueur, impossibles) à estimer en raison des nombreuses incertitudes physiques, temporelles, géographiques et sociales. Dans la fiche Réchauffement climatique : quel impact sur la croissance ? nous expliquons dans le détail fiche4 à quel point les méthodes utilisées par les économistes pour évaluer ces dommages sont contestables et conduisent à sous-estimer l’impact du réchauffement climatique sur l’économie.

Enfin, étant donné qu’il s’agit d’une analyse intertemporelle se pose évidemment la question du taux d’actualisation. Comme nous l’avons vu, plus le taux d’actualisation choisi est élevé, plus le futur est écrasé par rapport au présent. En conséquence, le poids des bénéfices futurs des investissements « climat » (c’est-à-dire les dommages climatiques évités) pèseront très faiblement dans la balance de l’analyse coût-bénéfice.

Selon le taux d’actualisation choisi pour la modélisation, les recommandations qui sortiront de l’analyse peuvent donc conduire à dissuader les investissements nécessaires pour éviter un réchauffement trop important, puisque ces derniers n’apparaissent jamais comme rentables.

C’est ce que nous allons voir en résumant dans la partie suivante l’une des plus célèbres polémiques autour du taux d’actualisation.

4.2 La polémique sur l’impact économique du réchauffement climatique

Si Norhdaus a commencé ses travaux sur la modélisation macroéconomique du climat dès la fin des années 1970, les résultats de la première version aboutie de son modèle DICE est publiée en 1994 dans son ouvrage « Managing the Global Commons ». Dans celui-ci, l’analyse coût-bénéfice réalisée aboutit à recommander une trajectoire d’émission de CO2 « optimale » (économiquement) menant à une concentration atmosphérique de CO2 de 650 ppm note14, soit plus de deux fois plus que la concentration pré-industrielle. Ses recommandations en matière de lutte contre le réchauffement climatique sont en conséquence plutôt limitées.

Episode 1 : Nordhaus / Cline

A cette époque, William Cline, un économiste moins reconnu, a déjà publié une analyse du même type note15 mais il préconise des réduction d’émissions nettement plus fortes.

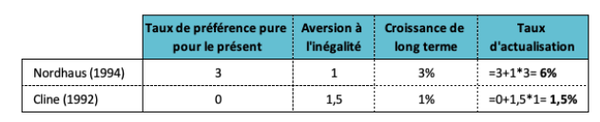

Pourtant, les deux économistes ont utilisé le même cadre d’analyse et des paramètres relativement similaires. La différence principale vient du taux d’actualisation utilisé : 6% pour Nordhaus et 1,5% pour Cline.

Comparaison des paramètre choisis par Nordhaus et Cline pour calculer le taux d’actualisation (selon la règle de Ramsey)

Dans son ouvrage, Nordhaus critique fortement les choix réalisés par Cline au motif que ceux-ci relèveraient d’un positionnement philosophique éloigné de l’attitude “positive” (neutre) qui devrait être celle d’un économiste. En effet, Cline a justifié son choix d’un taux de préférence pure pour le présent (TPPP) de 0% par le fait qu’il lui semblait éthiquement indéfendable de donner davantage de poids aux générations présentes qu’aux générations futures. Il aurait donc fixé le taux d’actualisation en se fondant sur ses croyances plutôt que sur les faits. note15bis

Episode 2 : Nordhaus / Stern

Douze ans plus tard, la polémique ressurgit mais fait cette fois beaucoup plus de bruit. Nicolas Stern, économiste reconnu, chef du service économique du gouvernement britannique et ancien économiste en chef de la Banque mondiale, adopte une position proche de Cline. Son rapport sur l’économie du changement climatique (2006) note16, remis en 2006 au ministère de l’économie et des finances britannique (HM Treasury), connaît un écho médiatique important.

C’est la première fois qu’est massivement relayé dans la presse et auprès des décideurs le fait que le réchauffement climatique pourrait avoir des conséquences économiques négatives importantes et qu’il est donc nécessaire de réduire rapidement et fortement les émissions de gaz à effet de serre.

Sur les nombreuses questions soulevées au long des plus de 600 pages du rapport, c’est le taux d’actualisation qui retient le plus l’attention des économistes. C’est également sur ce point que se concentrent leurs critiques note17. Pour les mêmes motifs que Cline, Stern a choisi un TPPP très faible (p=0,1%) note18.

Là encore, les économistes lui reprochent de ne pas s’être appuyé sur les taux de marché et de se laisser guider par sa propre opinion du changement climatique. Nordhaus l’accuse, par exemple, de s’autoproclamer, de par son choix de taux d’actualisation bas, planificateur social mondial... attisant les braises mourantes de l'empire britannique. note19.

Rappelons ici que les conséquences désastreuses du réchauffement climatique sur l’habitabilité de la planète ne sont pas une opinion mais sont un consensus scientifique parmi les climatologues.

Ces débats d’apparence techniques ne sont pas neutres.

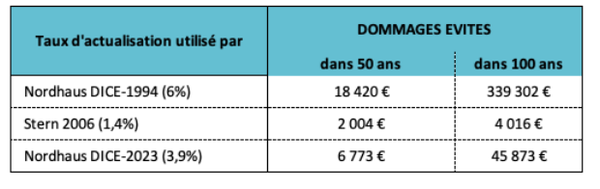

Si on ne peut évidemment imputer l’inaction climatique aux seules recommandations des économistes, il n’en reste pas moins que le discours de personnalités comme Nordhaus y a contribué. Pendant près de 15 ans, le message selon lequel le réchauffement climatique serait sans impact significatif sur le PIB à long terme a dominé auprès des décideurs politiques. Comme on le voit sur le tableau ci-après, selon le taux d’actualisation utilisé le niveau des bénéfices à attendre (les dommages climatiques évités) d’un investissement climat n’est pas du tout le même. Point besoin donc de mettre en œuvre des politiques climatiques trop ambitieuses. Nordhaus a, ainsi, longtemps préconisé des politiques climatiques très graduelles, commençant par de faibles réductions d’émissions et montant en puissance au cours du XXI° siècle. Le protocole de Kyoto était par exemple trop ambitieux à ses yeux.

Effets de différents taux d’actualisation sur le montant des dommages évités nécessaires pour rentabiliser 1000€ investis aujourd’hui dans les politiques climatiques.

Dans la première version de DICE (1994) il faut éviter 339 000€ de perte de PIB à 100 ans pour justifier 1000€ d’investissement aujourd’hui. C’est presque 85 fois plus qu’en utilisant le taux d’actualisation de Stern. Notons, que dans la dernière version de DICE (2023), malgré toutes les avancées de la science climatique, le taux utilisé par Nordhaus reste très élevé.

Prenons un autre exemple pour bien comprendre.

Celui-ci est volontairement extrême, et légèrement inspiré du film Don’t Look Up.

Supposons que :

-le PIB mondial, situé aujourd’hui autour de 93 000 milliards USD, croisse de 2% tous les ans, jusqu’à atteindre 673 000 milliards dans 100 ans.

-des astrophysiciens prévoient que dans 100 ans une comète atteindra la terre et détruira toute l’économie (sans parler des humains). PIB dans 100 ans et 1 jour = 0, pendant une durée infinie.

Avec un taux d’actualisation de 6%, combien les générations présentes seraient-elles prêtes à investir pour construire la machine permettant de détruire cette comète ?

Réponse : 52 000 milliards maximum, soit à peine 50% du PIB actuel pour éviter la fin de l’humanité !

4.3 Le choix du taux d’actualisation est nécessairement idéologique

Le principal argument des détracteurs de Cline ou de Stern repose sur le fait que ces derniers adopteraient un positionnement philosophique, non scientifique. Pourtant à y regarder de plus près leur approche ne l’est pas moins.

Le taux d’actualisation intègre deux paramètres par lesquels le présent compte plus que le futur

Le premier est évident : c’est le taux de préférence pure pour le présent (TPPP).

Le second est le taux de croissance de l’économie qui est postulé comme étant positif dans la quasi-totalité des modélisations. Le futur est de ce fait considéré, par construction, comme étant plus riche que le présent. Le taux de croissance étant combiné avec l’aversion à l’inégalité intertemporelle (qui valorise la période la plus pauvre), il en résulte un taux d’actualisation positif même si le TPPP est nul.

Or ce postulat d’un taux de croissance éternellement positif pose question en soi note20. Sans entrer dans le débat de l’impact de la mise en œuvre d’une vraie bifurcation écologique sur la croissance, la crise sanitaire, la crise énergétique, les premiers effets du dérèglement climatique ou de l’effondrement de la biodiversité permettent de poser légitimement la question de la possible voire probable décroissance future du PIB.

Le rapport des individus au futur se limite-t-il au seul taux de préférence pour le présent ?

La règle de Ramsey réduit les préférences des individus sur le futur au seul paramètre du TPPP, qui traduit une forme d’impatience de l’être humain. Comme le note Antonin Pottier, cette conception n’intervient que dans la seconde moitié du XXè siècle. Auparavant, les économistes avaient une conceptualisation plus riche du rapport au futur, leur raisonnement intégrait des motifs de legs, d’incertitude, d’autocontrainte. note21

Même en se limitant à refléter cette impatience, ce modèle de décision ne rend pas compte de la réalité. Par exemple, si une personne préfère recevoir un euro aujourd’hui plutôt que demain (ce qui montre une préférence pour le présent), alors elle est sensée préférer recevoir un euro dans un an plutôt que dans un an et un jour, alors qu’en général elle ne fait pas de différence entre les deux possibilités.

Peut-on véritablement déduire les préférences individuelles des agents économiques (résumés aux paramètres p et n) des taux d’intérêt observés sur les marchés ?

Si la formule de Ramsey fournit un cadre théorique de réflexion, elle n’est pas directement opérationnelle. En effet, ni le taux de préférence pure pour le présent, ni l’aversion à l’inégalité temporelle ne sont observables : ce sont des paramètres inconnus. Comme l’explique Antonin Pottier, pour rendre l’outil opérationnel, les économistes vont fixer le taux d’actualisation pour qu’il soit égal au taux d’intérêt dans l’économie.

En voici la justification supposons que le taux d’actualisation (disons a = 2 %) d’un agent économique soit plus bas que le taux d’intérêt (r = 5 %) : cet agent a alors intérêt à placer ses fonds disponibles aujourd’hui et à les consommer demain : 100€ placés rapporteront demain 105 €. Pour l’agent, cet argent consommé demain est équivalent à une consommation aujourd’hui de 105 / (1 + a) = 105 / 1,02 ≃ 103 (le taux d’actualisation ramène les valeurs futures (ici les 105 €) en équivalent de consommation présente). Cet équivalent de 103 € est supérieur aux cent euros de consommation que peut obtenir l’agent en dépensant cette somme aujourd’hui. L’agent, moins « impatient » que le reste de l’économie, cherche donc à épargner pour transmettre de la richesse dans le futur. L’arrivée de l’épargne que l’agent veut placer diminue le taux d’intérêt. L’équilibre est atteint lorsque le taux d’intérêt égalise le taux d’actualisation pour tous les agents : les agents ne veulent plus alors modifier leurs décisions d’épargner des fonds. note22

Un tel raisonnement n’est possible que dans un contexte extrêmement théorique : les préférences des agents sont toutes identiques (ils veulent maximiser leur consommation intertemporelle), ils sont rationnels, ils n’ont pas de contraintes pour emprunter, toute l’information est disponible, les prix transcrivent les volontés individuelles et ne doivent rien à l’irrégularité des transactions, au poids des fortunes à l’excitation du jeu. etc.

Ces conditions ne sont bien sûr jamais réalisées. Dans la réalité, les taux d’intérêt (variables selon les instruments financiers dont on parle) reflètent les frictions sur les marchés et non pas les anticipations des agents sur le futur, pas plus qu’une convergence idéale sur un marché qui ne fonctionne pas comme dans les modèles théoriques . L’argument qui vise à déduire le taux d’actualisation des taux de marché est donc infondé.

La décision collective est différente des décisions individuelles

L’objectif des analyses coût-bénéfice est d’éclairer l’action publique que ce soit pour le choix d’un investissement ou pour les décisions à prendre pour lutter contre le dérèglement climatique. La nature des décisions à prendre est donc très différente de celle que prendrait une entreprise ou un individu. D’un côté, on a la décision d’un agent privé impliquant son propre avenir (celui de son entreprise, le patrimoine d’un ménage) ; de l’autre la décision d’un État ou d’un territoire impliquant l’ensemble de la collectivité qu’il administre aujourd’hui et dans le futur.

Or dans la logique de la formule de Ramsey, la décision collective doit découler des préférences individuelles, telles qu’elles sont exprimées par les choix économiques et visibles sur les marchés via les taux d’intérêt. Comme le note Antonin Pottier c’est une conception particulière de la décision collective, qui n’a pas plus de légitimité qu’une autre. Certes, la décision collective doit avoir quelque rapport avec les choix individuels, tout au moins dans une société démocratique. C’est justement le rôle de la démocratie que d’instituer des procédures qui permettent de forger la décision collective à partir des avis individuels. Le recours au marché représente une procédure possible dont rien ne prouve qu’elle soit l’unique ou la meilleure, la plus morale ou la plus juste.

Prenons le cas du TPPP. A l’échelle du consommateur, on peut comprendre ce qui amène les économistes à lui attribuer une valeur positive : le consommateur peut être impatient, ou du moins souhaiter bénéficier de sa consommation dans le présent plutôt que dans un an, étant donné son risque non-nul de mourir dans l’année qui suit. A l’échelle macro-économique, le choix d’un TPPP positif pose plus de questions. Cela revient en effet à accorder ouvertement moins de poids aux générations futures dans la décision, ce qui soulève de sérieuses questions éthiques et d’équité intergénérationnelles. C’est pourquoi comme nous l’avons vu certains économistes tels que Cline ou Stern se positionnent pour un TPPP proche de 0. C’est donc bien un choix idéologique, au sens d’un choix de société. C’est d’ailleurs, également l’approche retenue par les économistes qui ont contribué au dernier rapport du GIEC.

We conclude that a broad consensus is for a zero or near-zero pure rate of time preference for the present

Ce choix n’est pas plus idéologique que de faire reposer le taux d’actualisation sur le postulat que les préférences collectives sont égales à la somme des préférences individuelles, que ces dernières sont guidées par la volonté de maximisation intertemporelle de la consommation et que celle-ci est correctement traduite par les taux d’intérêts observables sur les marchés.

Quelle que soit les justifications adoptées, le choix du taux d’actualisation reste donc bien un choix au plein sens du terme.

Le choix du taux d’actualisation a une importance déterminante pour tous les projets de long terme, et donc les projets de transition écologiques. Dans le domaine privé, ce choix est très dépendant du coût du financement et plus généralement du rendement attendu du capital : favoriser les projets de long terme implique donc d’agir à ce niveau. Dans le domaine public, il relève de la décision administrative : les marges de manœuvre semblent donc à priori plus grandes. Présentée comme technique et neutre, la détermination du taux d’actualisation est en réalité un choix au plein sens du terme qui relève bien plus de délibération collective que des débats d’experts. La littérature et les positions sont donc foisonnantes en la matière, et aucune méthode proposée ne permet d’arriver au consensus. Comme le dit Gaël Giraud : « il n’existe pas de [taux d’actualisation] note23 « naturel », et son choix relève d’une pure convention. En choisissant cette variable métaphysique, au fond, beaucoup d’économistes choisissent leur réponse aux problèmes écologiques » note24.

FICHE

FICHE

Pour en savoir plus

Pour en savoir plus

Retour

Retour Fiche en lien

Fiche en lien